在当今数据驱动的商业环境中,企业越来越依赖数据分析来驱动决策。无论是用户行为分析、业务报表还是运营监控,企业都需要具备快速、高效的数据处理能力。企业在数据分析能力上的演进,往往始于 TP(事务处理)系统,随着业务发展不断探索 TP 系统的扩展方案,最终走向构建独立的 AP(分析处理)系统。

企业实时分析典型演进过程

第一阶段:使用 TP 系统支撑事务处理和数据分析

在企业信息系统建设的早期,主要存储在 OLTP(在线事务处理)系统中,比如 PostgreSQL、MySQL、SQL Server 等。因为数据“就在那儿”,最自然的方式就是直接从 TP 系统中执行 SQL 查询来获取所需分析数据:

- 查询订单、用户、库存、交易等业务数据;

- 生成运营报表,支撑内部管理;

- 快速开发查询接口,满足临时的 BI 需求。

在业务初期,数据规模有限,分析需求也相对简单,系统架构轻量,能够高效支撑当下业务,避免了多系统部署和复杂数据流带来的额外成本与运维压力。然而,随着业务快速发展,数据量迅速增长,分析场景愈发复杂,查询延迟上升,事务与分析负载相互影响,原有系统逐渐难以支撑持续扩展的业务需求。

第二阶段:探索 TP 系统的扩展方案

为了在不破坏 TP 系统稳定性的前提下支撑持续扩展的业务需求,部分企业开始尝试基于 TP 的扩展方案。以下是行业中常见的做法与代表系统:

1. 分片与分布式扩展:Citus、TiDB、Vitesse

这些系统具备了基于关系数据库的水平扩展能力,使 TP 系统可以存储更大规模的数据并处理更高并发。

- Citus:是 PostgreSQL 的分布式扩展插件,可将表自动切分到多个节点,实现并行处理和查询加速。

- TiDB:兼容 MySQL 协议的分布式 HTAP 数据库,事务与分析融合,适用于在线业务+报表的场景。

- Vitesse:基于 MySQL 的分布式中间件,解决数据库扩展、容错和自动化问题,常用于大规模 TP 系统。

2. 读写分离与多副本架构:Amazon Aurora

- Amazon Aurora 提供了高性能、弹性扩展的云数据库,并支持最多 15 个只读副本,用于分担查询压力。这类方案适用于中等复杂度的分析任务,但在海量数据和复杂查询面前,Aurora 等 TP 架构依然面临查询瓶颈。

这些方案虽然在一定程度上缓解了单机性能瓶颈,但本质仍属于 TP 系统架构,难以根本解决事务与分析并存所带来的矛盾。面对大规模、多维度的聚合分析,这类系统能力有限,查询操作常常干扰写入,导致系统性能波动,影响整体稳定性。同时,架构复杂、运维门槛高,随着写入量和查询压力的持续上升,资源消耗不断加剧,系统成本快速攀升,性能瓶颈也日益显现。尤其在高吞吐数据导入和实时更新方面能力不足,限制了对业务变化的快速响应。而 TP 系统以行存为主的特性,使其在处理 TB 级以上数据的分析任务时,性能与专为分析设计的 AP 系统存在显著差距,难以胜任更复杂、更大规模的分析需求。

第三阶段:复杂分析使用 AP 系统

随着数据量不断增长、分析需求日益复杂,很多企业逐渐意识到,无法再依赖原有的 TP 系统同时满足事务处理与分析需求。因此,企业通常会将一些复杂的分析查询迁移到专门的 AP 系统中,例如 Redshift、Snowflake、BigQuery 等,用于支撑大规模的数据分析任务。而对于对实时性要求高、并发量大的查询,仍会保留在 TP 系统中运行,以确保系统的快速响应和稳定性。在一些高并发场景中,数据甚至会在 AP 系统中完成加工处理后,回流到 TP 系统中,进一步支撑实时查询和业务服务。

第四阶段:拥抱 AP 系统,实现分析计算与事务的解耦

随着数据规模持续扩大,事务处理系统(TP)的数据导入速度难以跟上行为数据生成的节奏,导致数据延迟持续增加。与此同时,部分复杂查询被转移到分析处理系统(AP)执行,其他分析任务仍在 TP 系统中完成,这使得系统运维难度和资源成本不断攀升,远超专门的 AP 系统。

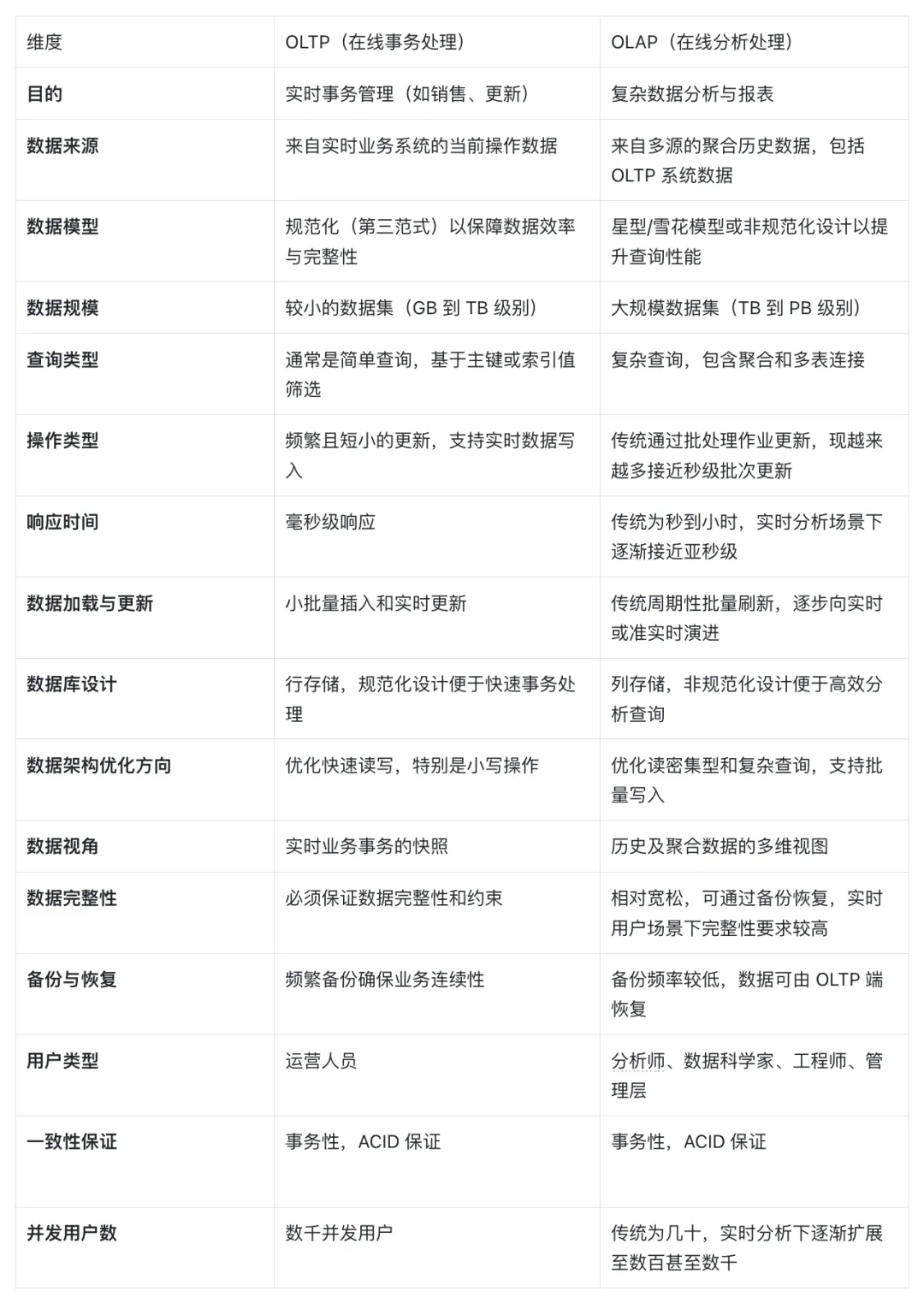

下表总结了 OLTP 与 OLAP 在关键维度上的主要区别,便于理解两者在架构定位上的差异。

OLTP vs OLAP 对比

面对这种挑战,越来越多企业开始认识到:对于实时分析场景,采用具备高并发与高性能的一体化 AP 系统来统一承载,能够大幅提升效率;而批量处理和离线分析等需求,则可以选择更适合的 AP 系统来完成。这样不仅优化了整体架构,也有效控制了成本,同时提升了数据分析能力,助力企业实现更加高效的数据驱动运营。

实时数据需求直接导入实时 OLAP 系统,常见做法是将事务处理系统(TP)与分析处理系统(AP)解耦,通过变更数据捕获(CDC)技术,实现 TP 系统数据的实时同步,同时行为数据也直接写入实时 OLAP。实时 OLAP 系统需具备快速更新能力和高效查询性能。该架构不仅避免了对核心业务系统的影响,还使企业能够第一时间获取并分析最新数据,广泛应用于用户行为分析、实时报表、风险监控等关键场景,显著提升了数据决策的及时性和价值。

OLAP 系统的选择:为什么是 Apache Doris?

Apache Doris 适合大数据量下需要高并发查询、AdHoc 和实时数据更新的场景:

低延迟高吞吐写入

支持多种数据导入方式,通过 Stream Load 可实现数据秒级可见、单节点写入吞吐可达百万行/秒,轻松满足海量数据的实时入库需求。

用户案例:网易云音乐

网易云音乐作为知名音乐流媒体平台,每天产生大量用户行为数据、业务数据及日志数据,这些数据在异常行为跟踪、客诉问题定位、运行状态监控、性能优化等方面扮演守护者的角色。面对每日万亿级别数据的增量,网易云音乐选择使用 Apache Doris 替换 ClickHouse 构建新的日志平台,目前已稳定运行 3 个季度,规模达到 50 台服务器,2PB 数据,每天新增日志量超过万亿条,峰值写入吞吐达 6GB/s。

在低延迟高吞吐写入场景中,网易云音乐采用 Flink + Doris Connector 实现流式数据无缝对接,通过多项关键优化措施显著提升了写入性能:

- 写入流程优化:在 append 数据操作时,直接写入压缩流,无需经过 ArrayList 中转,大幅降低内存使用,TM 内存占用从 8G 降至 4G,有效避免了因 batch size 设置过高导致的 OOM 问题。

- 单 tablet 导入功能:开启单 tablet 导入功能(要求表使用 random bucket 策略),极大提升写入性能,解决了写入 tablet 过多时元数据产生过多影响写入性能的问题。

- 负载均衡优化:每个 batch flush 完成后随机选择 BE 节点写入数据,解决 BE 写入不均衡问题,相较之前导入性能提升 70%。

- 容错能力增强:调整 failover 策略,优化重试逻辑并增加重试时间间隔,当 FE/BE 发生单点故障时能自动感知和重试恢复,保证服务高可用。

在元数据性能优化方面,针对 HDD 硬盘环境下 Stream Load 耗时突增问题,通过调整 3 台 Follower FE 为异步刷盘模式,实现了 4 倍性能提升,有效解决了同步元数据阶段的严重耗时问题。

整体收益显著:查询响应整体 P99 延迟降低 30%,并发查询能力从 ClickHouse 的 200 提升至 500+,写入稳定性大幅改善,运维成本显著降低,在坏盘和宕机场景下实现自恢复能力。

完整阅读:网易云音乐基于 Apache Doris 的万亿级日志平台建设实践

实时更新能力强

配合主流数据同步工具(如 Kafka、Canal、DataX、SeaTunnel 等)可实现从 TP 系统到 Doris 的准实时数据同步。其“Merge-on-Write”的更新机制兼顾写入性能与更新效率,适配主流 CDC 场景。

用户案例 :中通快递

随着中通快递业务的持续增长,昔日双 11 的业务高峰现已成为每日常态,原有数据架构在数据时效性、查询效率、与维护成本方面,均面临着较大的挑战。为此,中通快递引入 SelectDB,借助其高效的数据更新、低延时的实时写入与优异的查询性能,在快递业务实时分析场景、BI 报表与离线分析场景、高并发分析场景中均进行了应用实践。

在实时分析场景中,基于 SelectDB 灵活丰富的 SQL 函数公式、高吞吐量的计算能力,实现了结果表的查询加速,能够达到每秒上 2K+ 数量级的 QPS 并发查询,数据报表更新及时度大大提高。

SelectDB 的引入满足了复杂与简单的实时分析需求。目前,SelectDB 日处理数据超过 6 亿条,数据总量超过 45 亿条,字段总量超过 200 列,并实现服务器资源节省 2/3、查询时长从 10 分钟降至秒级的数十倍提升。

案例回顾:中通快递基于 SelectDB 实时数仓的应用实践

极致的查询性能

Doris 天生为分析优化,具备列式存储、向量化执行引擎、位图索引、多级缓存、物化视图等优化手段,能够支撑亚秒级的分析响应时间,并支持复杂的多维分析、聚合与 JOIN 查询。

用户案例 :拉卡拉

拉卡拉(股票代码 300773)是国内首家数字支付领域上市企业,从支付、货源、物流、金融、品牌和营销等各维度,助力商户、企业及金融机构数字化经营。随着实时交易数据规模日益增长,拉卡拉早期基于 Lambda 架构构建的数据平台面临存储成本高、实时写入性能差、复杂查询耗时久、组件维护复杂等问题。拉卡拉选择使用 Apache Doris 替换 Elasticsearch、Hive、HBase、TiDB、Oracle/MySQL 等组件,完成 OLAP 引擎的统一,实现了查询性能提升 15 倍、资源减少 52% 的显著成效。

在极致查询性能场景中,拉卡拉充分发挥了 Apache Doris 天生为分析优化的多项能力,在金融核心业务中实现了显著的性能提升:

- 风控场景查询优化:替换 Elasticsearch 后,查询响应时间从 15 秒缩短至 1 秒以内,查询性能提升 15 倍。Doris 的标准 SQL 查询接口和强大的多维分析能力,支持复杂的多表 JOIN、子查询和窗口函数等场景。

- 对账单系统高并发处理:借助 Doris 优秀的并发处理和极速查询能力,支持每日亿级数据规模和百万级查询请求,查询 99 分位数响应时长控制在 2 秒以内,数据延迟可控制在 5 秒。

- 倒排索引加速大表关联:通过添加倒排索引、调整分桶策略以及表结构优化,大表关联查询耗时从 200 秒缩短至 10 秒,查询效率提升超过 20 倍。

- Light Schema Change 灵活变更:相比 Elasticsearch 需要通过 Reindex 进行 Schema 变更,Doris 的 Light Schema Change 机制更加高效灵活,支持字段和索引的快速增删修改,极大提升了数据管理的便捷性和业务适应性。

整体收益显著:服务器数量下降 52%,开发运维效率大幅提升,通过统一的 OLAP 引擎简化了技术架构,降低了学习成本和运维复杂性。

完整阅读:拉卡拉 x Apache Doris:统一金融场景 OLAP 引擎,查询提速 15 倍,资源直降 52%

高并发处理能力

得益于 MPP 架构,Doris 可轻松扩展计算资源,支持海量用户并发访问分析报表,是支撑数据门户、运营后台、用户行为分析等实时应用场景的理想方案。

用户案例:快手

快手作为知名短视频平台,OLAP 系统为内外多个场景提供数据服务,每天承载近 10 亿的查询请求。原有湖仓分离架构面临存储冗余、资源抢占、治理复杂等问题。快手通过引入 Apache Doris 湖仓一体能力替换 ClickHouse,升级为湖仓一体架构,涉及数十万张表、数百 PB 的数据增量处理。

在高并发处理场景中,Apache Doris 凭借强大的 MPP 架构和分布式查询引擎,为快手提供了卓越的并发查询支撑能力:

- 海量并发查询支撑:系统每天承载近 10 亿查询请求,覆盖 ToB 系统(商业化报表引擎、DMP、磁力金牛、电商选品)和内部系统(KwaiBI、春节/活动大屏、APP 分析、用户理解中心等)的高并发访问需求。

- 智能查询路由:通过查询路由服务分析和预估查询的数据扫描量,将超大查询自动路由到 Spark 引擎,避免大查询占用过多 Doris 资源,确保高并发场景下的系统稳定性。

- 物化视图透明改写:结合 Doris 的物化视图改写能力和自动物化服务,实现查询性能提升至少 6 倍,百亿级别以下数据可实现毫秒级响应,有效支撑高并发查询场景。

- 缓存优化加速:通过元数据缓存和数据缓存双重优化,元数据访问平均耗时从 800 毫秒降至 50 毫秒,显著提升高并发场景下的查询响应效率。

整体收益:实现了统一存储和链路简化,无需数据导入即可直接访问湖仓数据,在支撑海量并发查询的同时大幅降低了运维复杂度和存储成本。

完整阅读:快手:从 Clickhouse 到 Apache Doris,实现湖仓分离向湖仓一体架构升级

统一数据体验 Doris 提供类 SQL 的接口,兼容 MySQL 协议,易于 BI 工具对接(如 Tableau、Power BI、Superset 等),同时可通过视图、物化视图等能力,提供类似数据仓库的建模支持。

可以满足的典型场景包括:

- 面向用户的实时分析(Customer-Facing Analytics) 将订单、交易、行为等业务数据从数据库中捕获并同步至实时数仓(如 Apache Doris),支持用户在前端系统中秒级查看订单状态、活动参与情况、积分变化等。提升用户体验的同时,也为推荐、搜索等系统提供最新的数据支持。

- 运营监控与分析 运维、客服、市场等部门可以实时查看关键指标(如系统交易量、失败率、退货率),并快速响应业务波动。CDC 保证了数据与业务系统的实时一致性,使监控结果具有可信度。

- 模型训练与特征回填 将用户行为日志和业务数据同步到分析库后,ML 工程师可以基于最新数据生成训练样本、回填特征值,显著加快模型迭代速度,提升预测准确率。

- 多维分析与自助 BI 将结构化业务数据实时汇聚到 OLAP 系统,结合维度模型,支持业务人员进行灵活多维分析,满足从明细到聚合的多层级洞察需求,减少对开发人员的依赖。

ClickHouse 实时更新原理

在 ClickHouse 中,虽然底层存储以追加为主,但通过 ReplacingMergeTree 引擎,用户可以实现类似“实时更新”的效果。其核心思想是:在写入时保留所有版本的数据,在后台合并时自动保留最新版本,从而实现数据的“更新”。

详情参考文档

具体工作原理如下:

- 写入阶段 使用

ReplacingMergeTree创建表时,通常会指定一个唯一标识列(如主键)和一个版本列(如update_time)。每次对同一主键的数据更新时,系统不会直接覆盖旧数据,而是插入一行新版本的记录。 - 合并阶段(Merge) ClickHouse 的后台合并线程会在空闲时自动执行数据文件的合并操作。对于

ReplacingMergeTree表,合并过程中会根据主键值和版本列,自动保留每组主键下版本最新的记录,删除旧版本,实现最终的“更新”语义。 - 查询阶段 查询过程中可能会读到尚未合并的多个版本记录,因此建议设置

FINAL查询语法,如:

SELECT * FROM my_table FINAL;

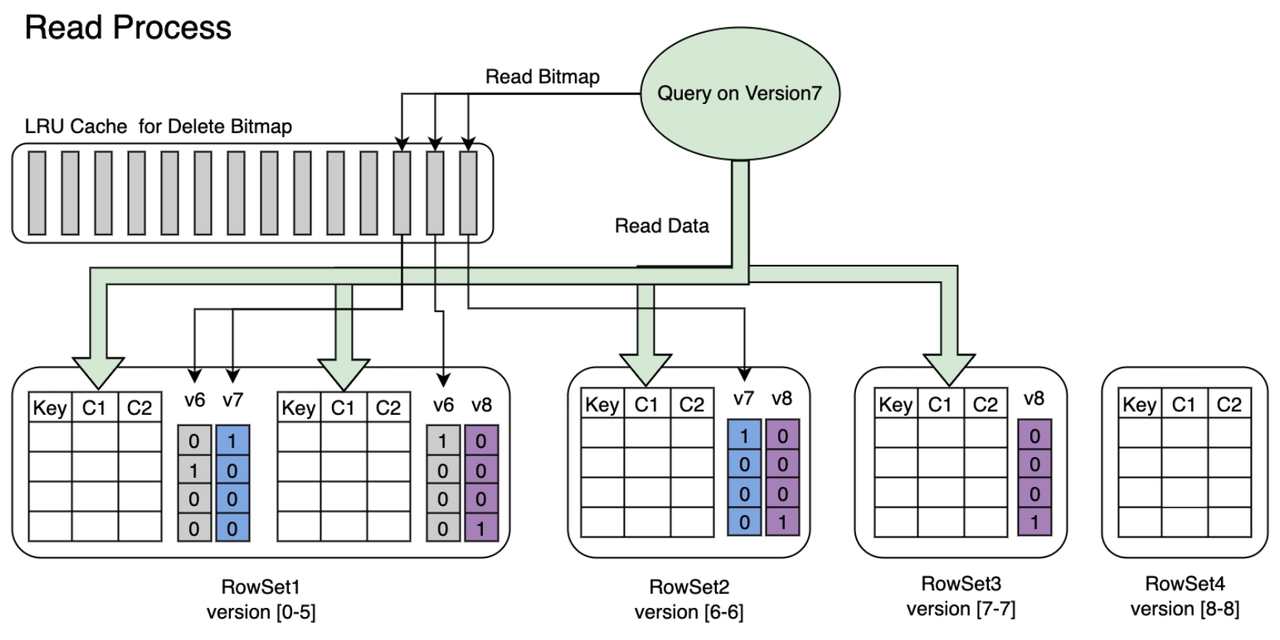

Apache Doris 实时更新原理

在需要频繁更新数据的场景中,可以使用 Doris 提供的 Unique Key 模型来建表,实现对同一主键的数据进行高效覆盖更新。Doris 通过一种名为标记删除(Delete Bitmap)的机制,有效提升查询性能。与 ClickHouse 查询时进行更新清理的方式不同,Doris 的标记删除机制无需在查询时实时计算删除逻辑,因此可以显著减少查询延迟,确保查询响应时间稳定在百毫秒以内,并支持高并发访问。

具体来说,Doris 的处理分为两个阶段:

- 写入阶段 在使用 Unique Key 创建表时,您通常会指定一个唯一标识(如主键 ID)和一个版本列(如更新时间

update_time)。每当新数据写入时,如果主键相同且版本更新,Doris 会自动为旧数据打上“删除标记”,这些信息随着数据一同写入底层存储。 - 查询阶段 在查询过程中,Doris 会自动识别并跳过那些已被标记删除的旧数据行,无需实时对比或扫描多个版本,从而实现低延迟、高效率的数据读取。

借助这套机制,Doris 能够同时满足 实时更新 和 高速查询 的双重需求,非常适合用于用户画像、订单中心、指标快照等典型更新型分析场景。

性能对比

当分析负载从 TP 或者 HTAP 演进到 AP 时,一个常见场景是将 TP 系统中的变更数据(通过 CDC)同步到 AP 系统,用于后续的报表分析和业务监控。这类场景通常涉及大量的数据更新,而不仅仅是新增数据,因此对分析系统的更新处理能力和查询性能提出了更高要求。

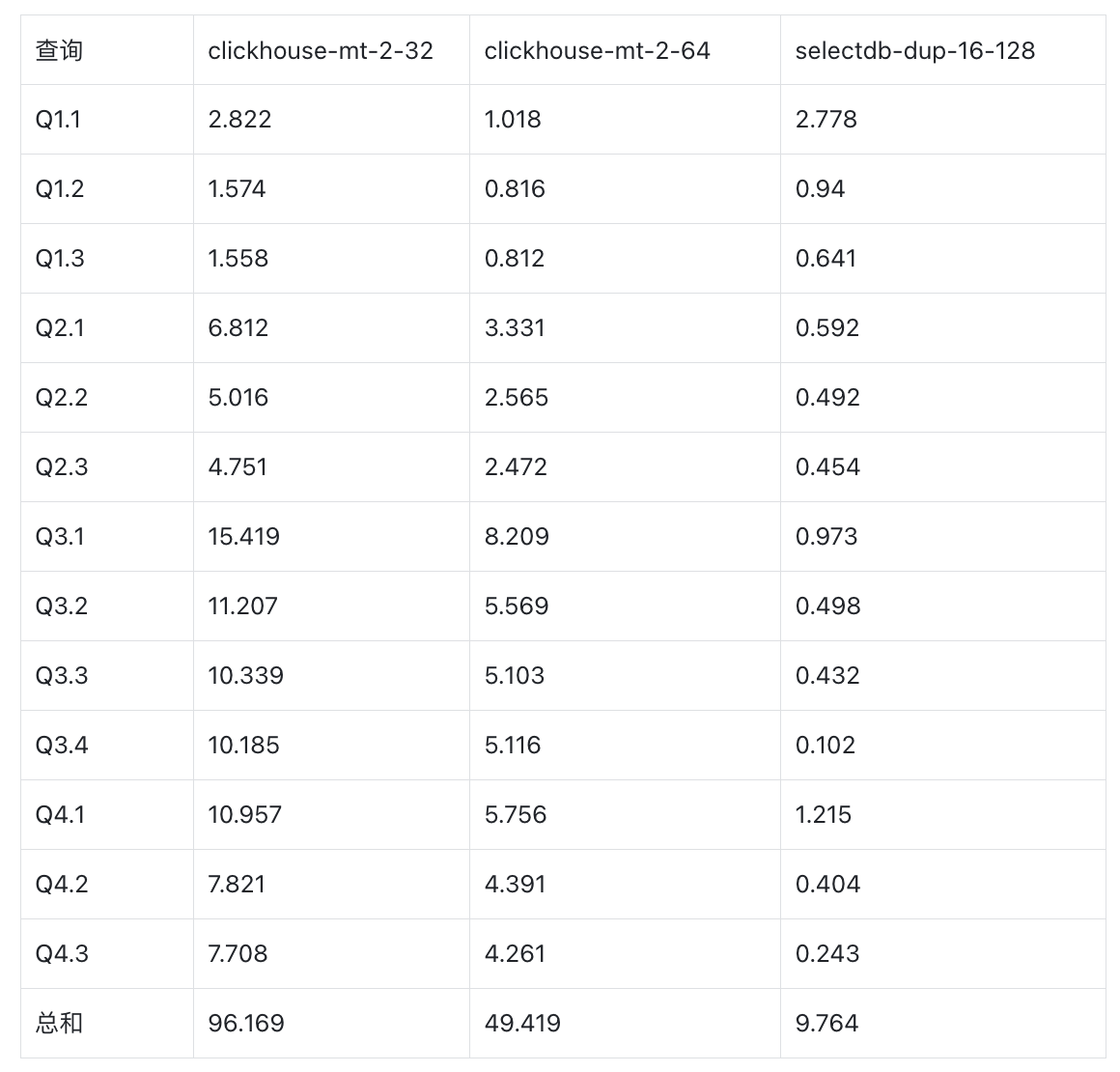

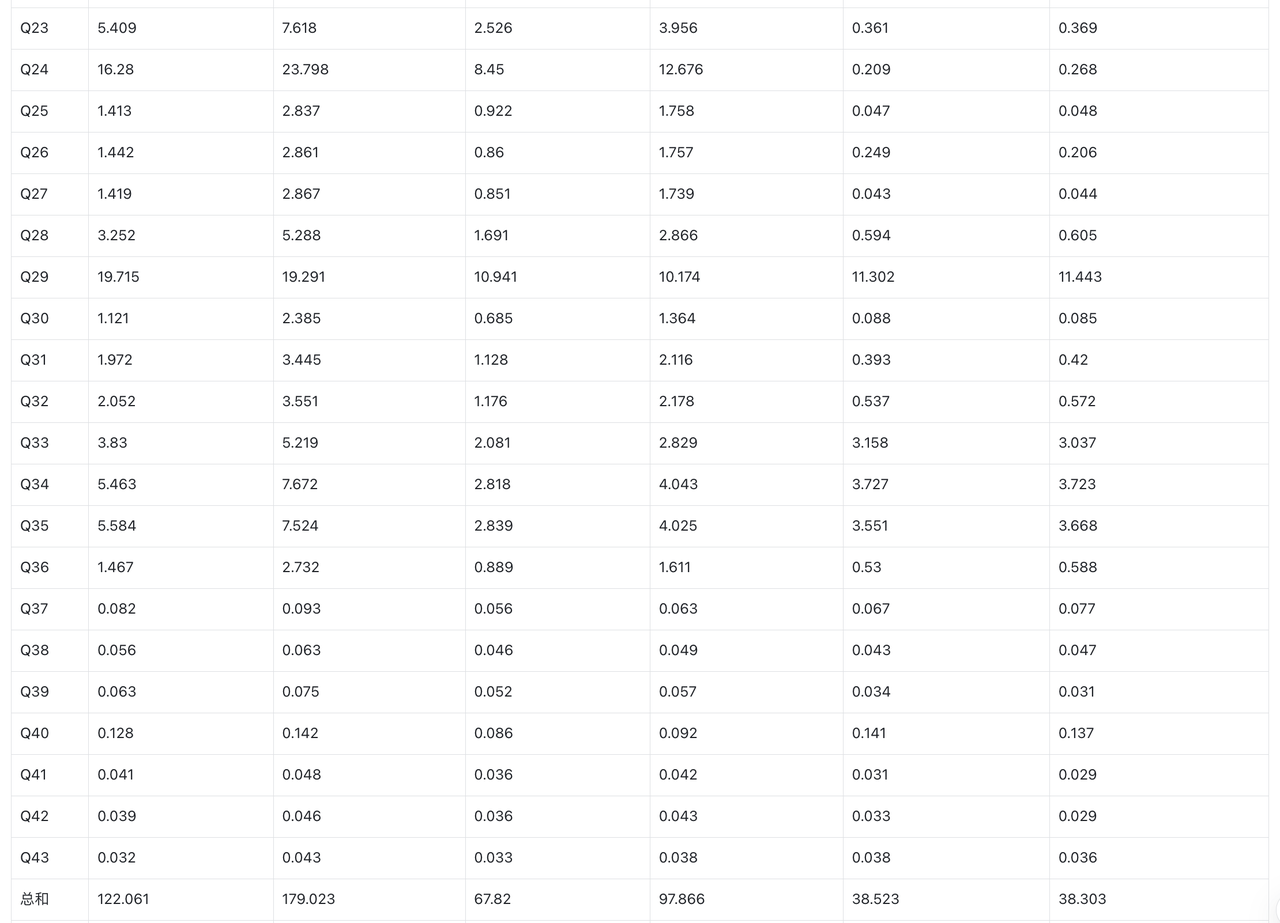

为了评估 Doris 和 ClickHouse 在这一类实时更新分析场景下的表现,我们基于典型的行业测试模型 ClickBench 和 SSB(Star Schema Benchmark) 进行了测试,分别对数据集中的 25% 和 100% 的记录进行了更新操作。

更新 SQL 详情参考

为确保性能对比的合理性,结合 ClickHouse Cloud 与 SelectDB Cloud 套餐配置的差异,制定了如下测试方案:ClickHouse Cloud 采用双副本,单副本分别配置为 8 核 32GB 和 16 核 64GB;SelectDB Cloud 则采用单副本 16 核 128GB 配置。通过该设计,可在整体资源层面分别实现核数对等(16 核)与内存对等(128GB)的横向对比,从而更全面地评估两者在不同资源维度下的性能表现。

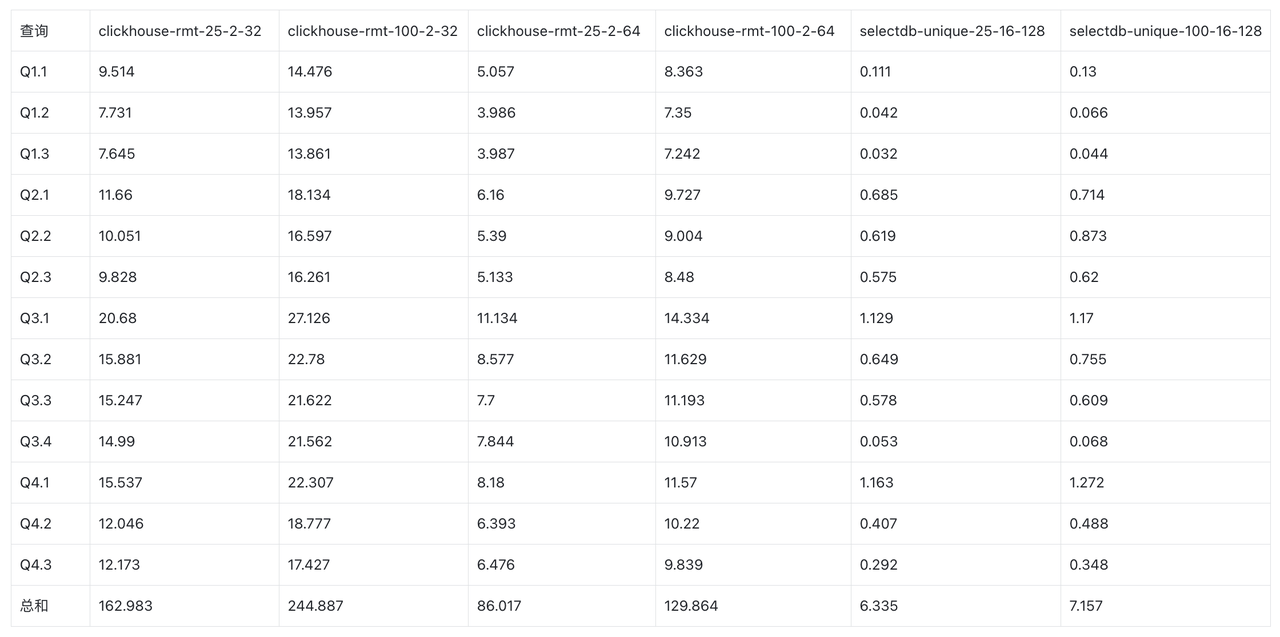

原始数据:ssb

SSB-sf100

ClickHouse MergeTree vs SelectDB Duplicate Key

- SelectDB (16c 128GB)的性能是 ClickHouse 32c 128GB(2 replica 每个 replica 16c 64GB)的 5 倍。

- SelectDB (16c 128GB)的性能是 ClickHouse 16c 64GB(2 replica 每个 replica 16c 64GB)的 9.8 倍。

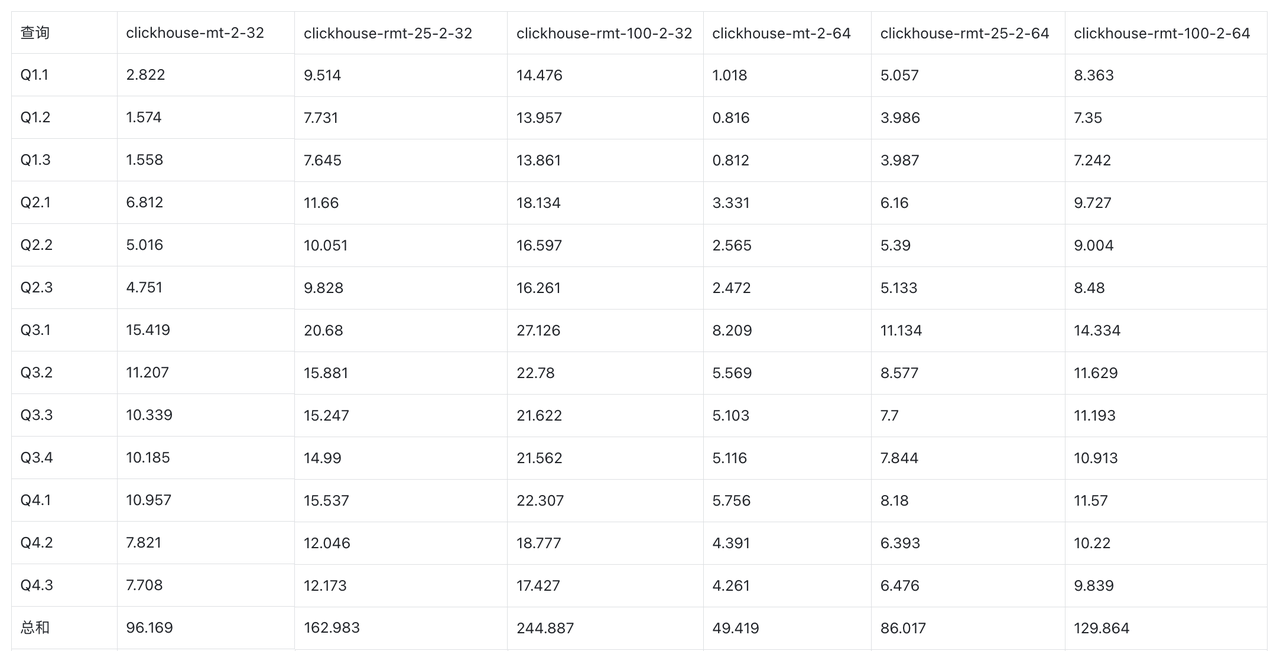

ClickHouse MergeTree vs ReplacingMergeTree

- 25% 更新比例下,ClickHouse ReplacingMergeTree 相比 MergeTree 性能下降 1.6 倍。

- 100% 更新比例下,ClickHouse ReplacingMergeTree 相比 MergeTree 性能下降 2.5 倍。

ClickHouse ReplacingMergeTree vs SelectDB UniqueKey

- SelectDB (16c 128GB)相比 ClickHouse 32c 128GB(2 replica 每个 replica 16c 64GB)

- 25% 更新比例条件下,SelectDB 的性能是 ClickHouse 的 14 倍。

- 100% 更新比例条件下,SelectDB 的性能是 ClickHouse 的 18 倍。

- SelectDB (16c 128GB)相比 ClickHouse 16c 64GB(2 replica 每个 replica 8c 32GB)

- 25% 更新比例条件下,SelectDB 的性能是 ClickHouse 的 25 倍。

- 100% 更新比例条件下,SelectDB 的性能是 ClickHouse 的 34 倍。

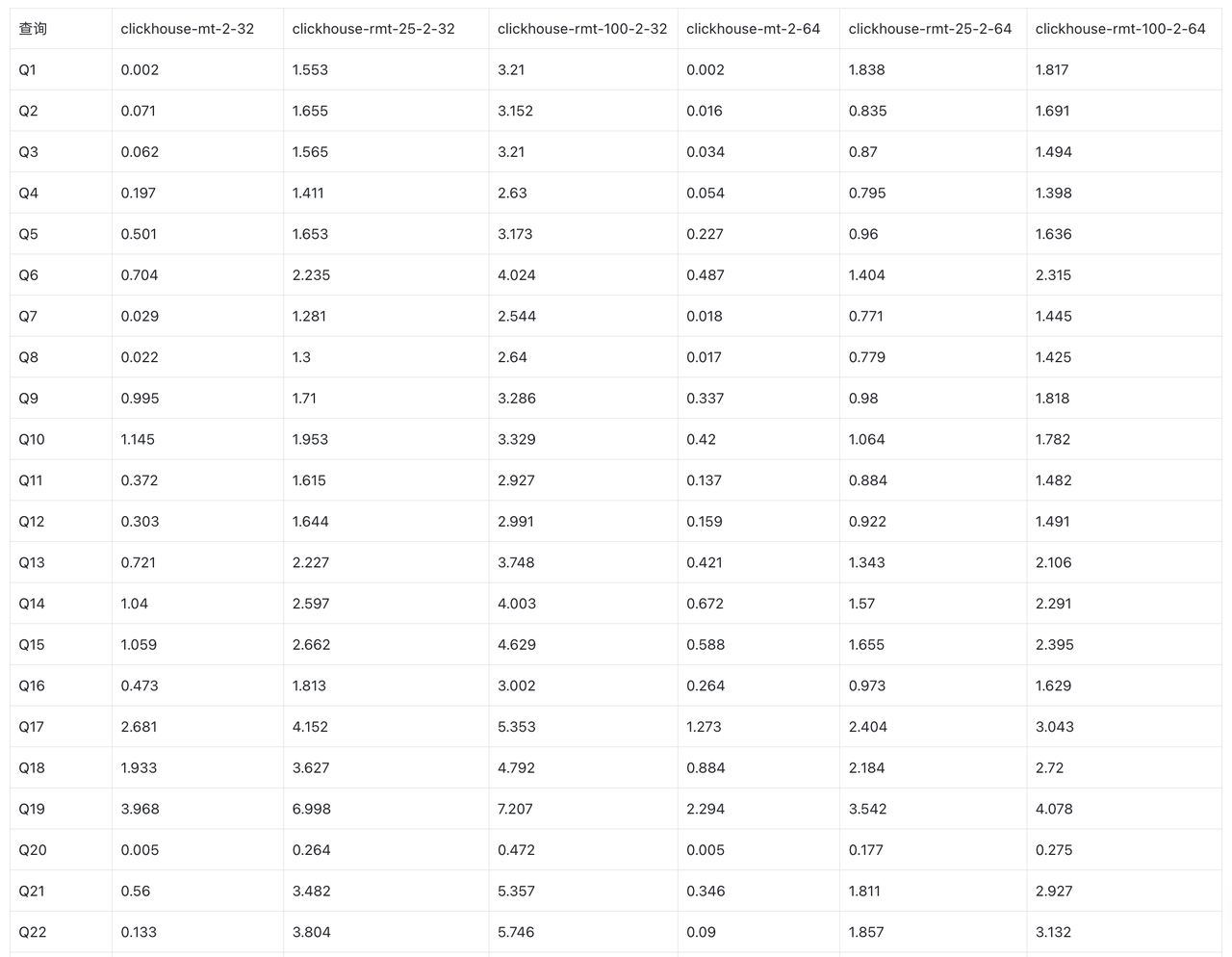

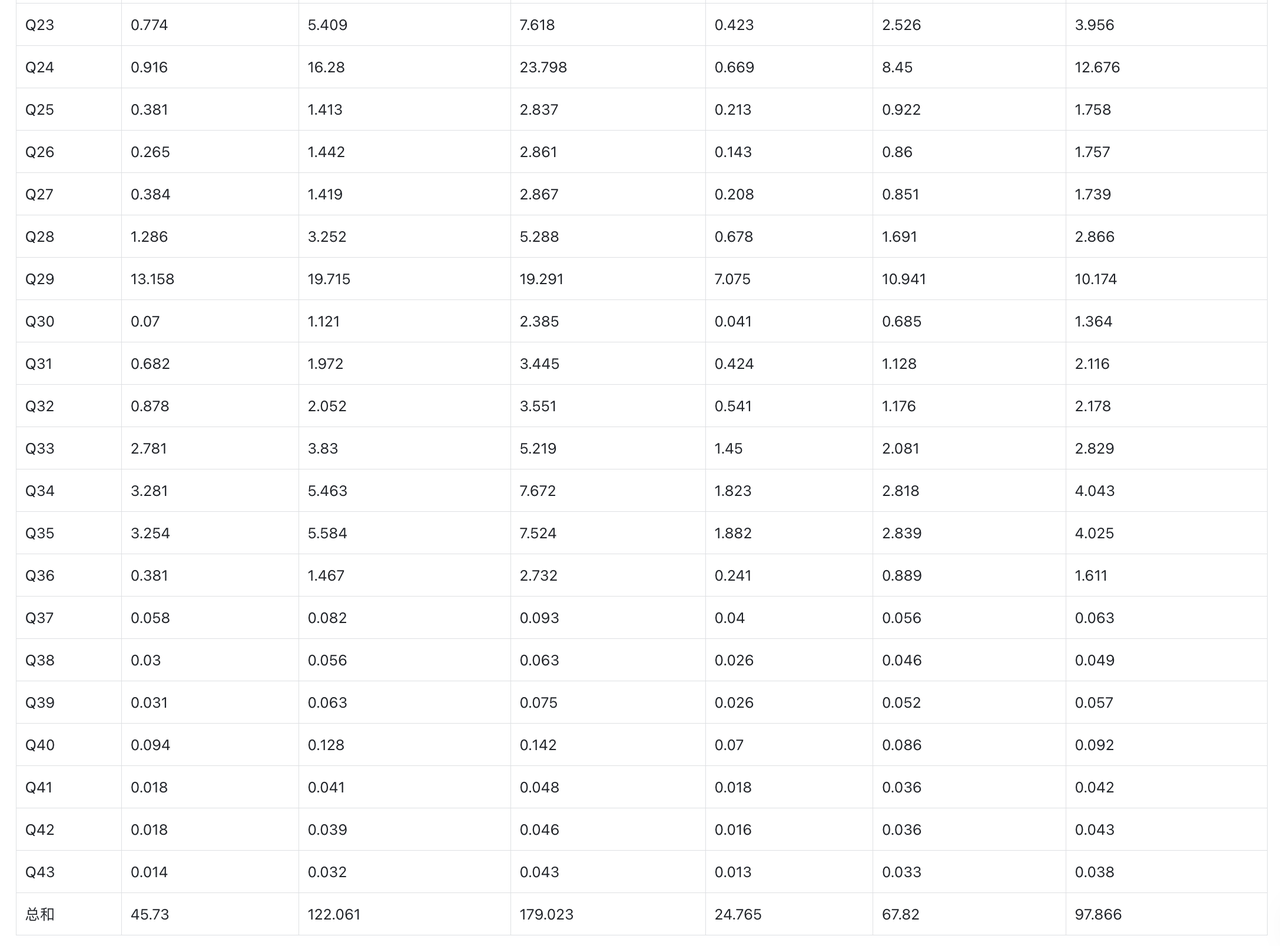

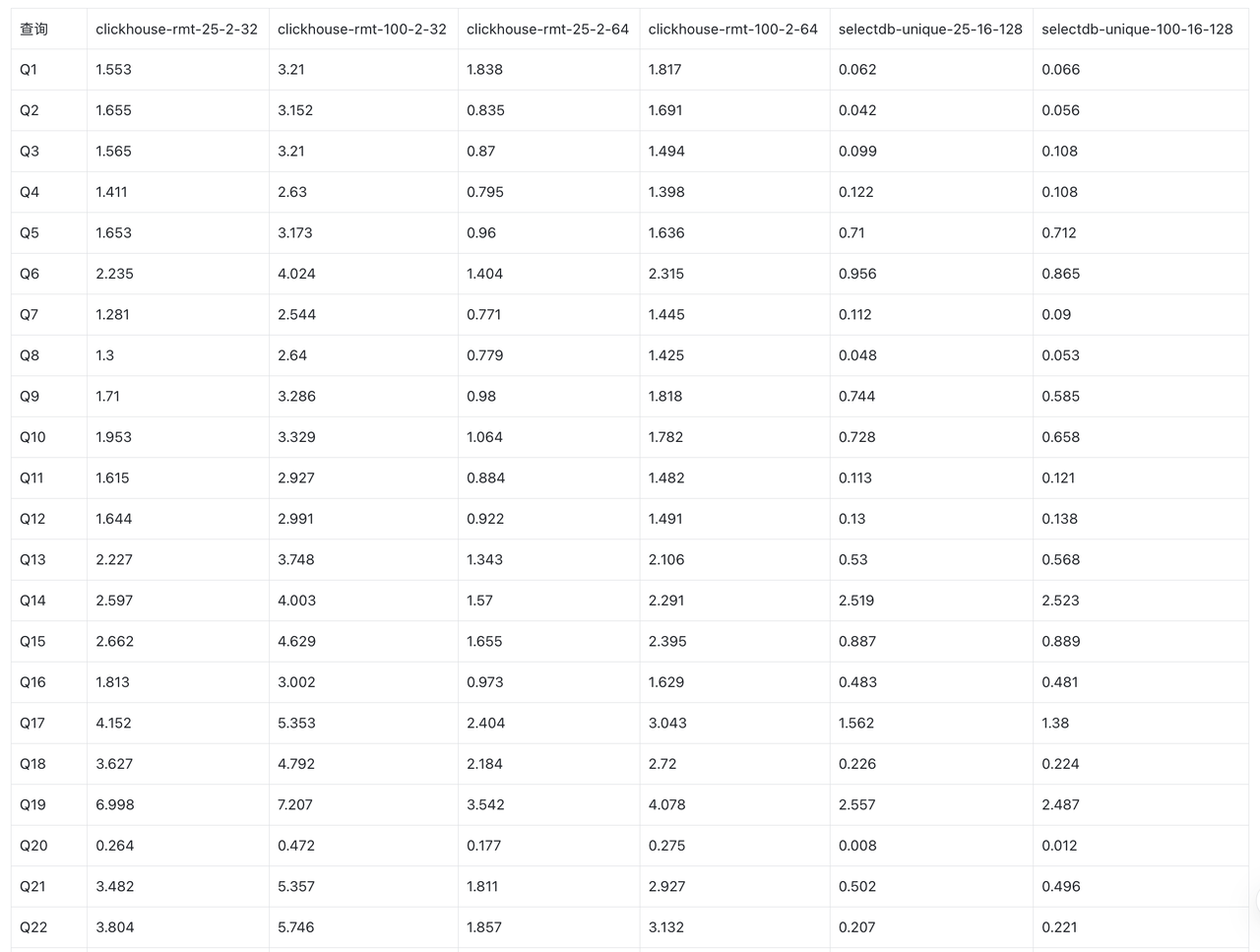

ClickBench

原始数据:clickbench

ClickHouse MergeTree vs ReplacingMergeTree

- ClickBench 下 25% 更新比例 ClickHouse ReplacingMergeTree 相比 MergeTree 性能下降超过 170%。

- ClickBench 下 100% 更新比例 ClickHouse ReplacingMergeTree 相比 MergeTree 性能下降超过 290%。

ClickHouse ReplacingMergeTree vs SelectDB UniqueKey

- SelectDB (16c 128GB)相比 ClickHouse 32c 128GB(2 replica 每个 replica 16c 64GB)

- 25% 更新比例条件下,查询耗时低 43%

- 100% 更新比例条件下,查询耗时低 60%

- SelectDB (16c 128GB)相比 ClickHouse 16c 64GB(2 replica 每个 replica 8c 32GB)

- 25% 更新比例条件下,查询耗时低 68%。

- 100% 更新比例条件下,查询耗时低 78%。

用户案例

案例一:森马服饰(MySQL)

森马服饰作为中国休闲服饰和童装领域的领先企业,覆盖线上线下全渠道零售,门店总数达到 8000+ 家。为支撑全域货通中台项目,森马引入阿里云 SelectDB 替换原 Elasticsearch + 分布式 MySQL 混合架构,统一分析 16+ 核心业务,实现复杂查询 QPS 提升 400%,响应时间缩短至秒级。

在高并发处理场景中,阿里云 SelectDB 凭借 MPP 架构为森马提供了强大的并发查询支撑:

- 多场景并发支撑:同时支撑 2B 业务、2C 业务、直营店、加盟商等多场景下的高并发数据分析需求,复杂查询 QPS 达到 200+ 水平。

- 资源隔离能力:基于存算分离架构,在线订单查询服务和离线聚合分析 BI 场景分别使用独立计算组,避免相互干扰,确保高并发场景下系统稳定性。

- 弹性扩缩容:在直播大促等高压力时段,可快速在线扩容应对流量激增,无需停服和数据搬迁,显著提升应对突发高并发的灵活性。

- 统一架构简化:替换双系统架构,统一支持简单过滤查询、海量数据聚合分析、复杂多表关联查询,无需维护复杂业务逻辑来处理高并发多表关联分析。

显著收益:亿级库存流水聚合查询缩短至 8 秒内,运维成本大幅降低,业务高峰期系统运行平稳,为全渠道运营提供可靠的高并发数据分析支撑。

完整阅读:森马服饰从 Elasticsearch 到阿里云 SelectDB 的架构演进之路

案例二:天眼查(PostgreSQL)

天眼查是一家数据服务公司,为用户提供超过 3 亿家企业的商业、财务和法务信息查询服务,涵盖 300+ 维度数据。随着业务增长,其尽调平台需要支持内部营销和运营团队的即席查询及用户分群等新需求。该平台使用 Apache Doris 替换了原有的 Apache Hive、MySQL、Elasticsearch 和 PostgreSQL 混合架构,实现数据写入效率提升 75%,用户分群延迟降低 70%。

在高并发处理场景中,Apache Doris 的 MPP 架构为平台提供了强大的并发查询支撑能力:

- 即席查询能力:原架构每次新需求都需要在 Hive 中开发测试数据模型,写入 MySQL 调度任务。现在 Apache Doris 拥有全量明细数据,面对新请求只需配置查询条件即可执行即席查询,仅需低代码配置即可响应新需求。

- 高效用户分群:在结果集小于 500 万的用户分群场景中,Apache Doris 能够实现毫秒级响应。通过连续密集的用户 ID 映射优化,用户分群延迟降低 70%,显著提升高并发分群任务处理效率。

- 统一架构简化:消除了多组件间的复杂读写操作,无需预定义用户标签,标签可基于任务条件自动生成,大幅简化用户分群流程,提高 A/B 测试的灵活性。

- 稳定数据写入:支持每天近 10 亿条新数据流入,使用不同数据模型适配不同场景(MySQL 数据采用 Unique 模型,日志数据采用 Duplicate 模型,DWS 层数据采用 Aggregate 模型)。

显著收益:数据仓库架构更加简单,对开发者和运维人员更加友好,2 个 Apache Doris 集群承载数十 TB 数据,为客户提供实时、准确的企业信息查询服务。

完整阅读:秒级数据写入,毫秒查询响应,天眼查基于 Apache Doris 构建统一实时数仓

案例三:宝舵 BOCDOP(TiDB)

宝舵是宝尊集团旗下商业化独立品牌,拥有 1000 余名技术工程师,为集团 8000+ 员工和全球 450+ 品牌提供电商全渠道数据分析服务。宝舵早期基于 TiDB 构建实时数仓,随着数据量增长面临处理效率、OLAP 扩展、成本等挑战。通过引入 SelectDB 替换 TiDB,实现写入速度提升 10 倍,成本直降 30% 的显著成效。

在实时更新场景中,SelectDB 为宝舵提供了强大的实时数据处理能力,特别体现在多源数据同步方面:

- 多源异构数据实时接入:支持 100+ 业务模块的多渠道数据实时接入,通过 Canal、Mongo-Connector、OGG 等工具获取 MySQL、MongoDB、Oracle 等不同类型业务数据库的 binlog,实现秒级延迟数据同步。

- 高吞吐实时写入:利用分区分桶策略与单副本写入机制,在双 11 峰值时段实现每秒百万级数据写入,最高写入速度从 20 万/分提升至 230 万/分,较传统方案提升 10 倍。

- 流式数据处理:通过 Kafka + Flink + SelectDB 流式写入能力,将分散在订单、支付、物流等业务模块的数据实时汇聚,数据同步提速 30%。

- 资源隔离保障:为"作战室看板"单独分配计算资源组,避免高并发查询与实时写入的资源争用,确保关键业务查询响应时间稳定在 500ms 内。

显著收益:在双 11 等大促期间数据量达平日 30-60 倍的情况下,实现数据供应 0 事故、报表服务可用性 99.9%,查询性能提升 66%,为多渠道电商运营提供稳定的实时数据支撑。